A ferramenta Websensors foi desenvolvida para mineração de dados e textos e está sendo utilizada na análise da evolução da pandemia de COVID-19. Capaz de extrair dados de textos de notícias, obtendo informações sobre “o que aconteceu”, “quando aconteceu” e “onde aconteceu”, a Websensors possibilita ajustar, dia a dia, os modelos de propagação da doença.

A tecnologia foi elaborada no Instituto de Ciências Matemáticas e de Computação da Universidade de São Paulo (ICMC-USP), em São Carlos, pelos pesquisadores Solange Rezende, Ricardo Marcacini e Rafael Rossi, teve também a participação de Roberta Sinoara. Também recebeu apoios da FAPESP por meio do projeto “Aprendizado de máquina para WebSensors: algoritmos e aplicações”, e de bolsas concedidas a Marcacini, Rossi e Sinoara.

Segundo Rezende, a principal questão investigada na pesquisa da Websensors é a possibilidade de extrair informações complementares sobre um problema a partir de notícias e, com base nelas, ajustar os modelos preditivos já existentes. “Nós usamos mineração de dados em textos de notícias como forma de identificar eventos que estão ocorrendo em cada país e, assim, ajustar a projeção com as características do Brasil”, diz pesquisadora.

A ferramenta utiliza uma metodologia de mineração de eventos estruturada em cinco etapas: identificação do problema; pré-processamento; extração de padrões; pós-processamento; e uso do conhecimento.

A primeira etapa, a da identificação do problema, consiste em definir o escopo da aplicação e as fontes de dados. “Os dados diários de propagação internacional da COVID-19 são coletados no Data Repository by Johns Hopkins CSSE. E as notícias, publicadas em mais de 100 idiomas, são obtidas por meio do GDELT Project. Essa grande plataforma, altamente seletiva, nos protege contra fake news”, explica Rezende.

Na segunda etapa, a do pré-processamento, são utilizados algoritmos que transformam as notícias em eventos. “Queremos apenas notícias em que possamos identificar o que aconteceu, quando aconteceu e onde aconteceu. Quando pelo menos essas três informações podem ser extraídas da notícia, então temos um evento, que um programa de computador possa analisar”, explica Marcacini.

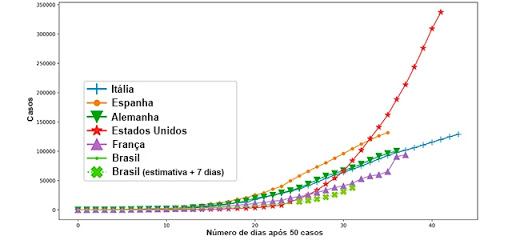

Na terceira etapa, a da extração de padrões, é empregada uma rede neural que recebe, como entrada, as curvas de contágio de alguns países. E as enriquece, adicionando os eventos pré-processados na etapa anterior. “Como saída, nós configuramos a rede neural para que ela retorne à curva de contágio, considerando as características do Brasil”, relata Marcacini.

No pós-processamento, que configura a quarta etapa, os responsáveis pela ferramenta fazem uma avaliação do modelo utilizado. “Diferentes técnicas de avaliação podem ser empregadas. Uma delas é usar o modelo para prever alguns dos dados que já conhecemos e, assim, quantificar a margem de acertos.”, diz Rezende.

A quinta e última etapa, finalmente, diz respeito ao uso do conhecimento. Isso significa disponibilizá-lo para ser explorado por usuários ou mesmo por outros sistemas. No caso, todo o conhecimento obtido acerca da pandemia pode ser acessado abertamente no endereço http://websensors.net.br/projects/covid19/.

Rezende afirma que a plataforma Websensors tem publicado diariamente as previsões dos próximos sete dias da curva de contágio do Brasil, usando o modelo ajustado com os eventos. As informações encontram-se disponíveis para qualquer interessado. Mas alerta para o fato de que a ferramenta ainda está recebendo ajustes. “É importante ressaltar que a Websensors não foi construída para essa finalidade. No entanto, acreditamos que, nesse período difícil, podemos utilizar o que temos à disposição para colaborar”, salienta.